搜索引擎分类:

- 全文搜索引擎

- 目录搜索引擎

- 元搜索引擎

一、页面抓取流程

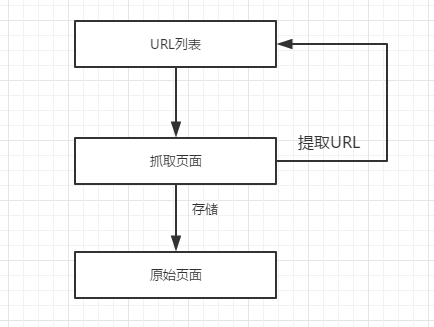

在互联网中,URI是每个页面的人口地址,搜索引擎蜘蛛程序就是通过URL抓取到页面的。搜索引擎蜘蛛程序从原始UR列表出发,通过URL抓取并存储原始页面;同时,提取原始页面中的UR资源并加入到URU列表中。如此不断地循环,就可以从互联网中获取到足够多的页面,如图:

URL是页面的入口,二域名则是一个网站的入口。搜索引擎蜘蛛程序通过域名进入网站,从而展开对网站页面的抓取。换而言之,搜索引擎要在互联网上抓取到页面的首页任务就是建立一个足够大的原始域名列表,在通过域名进入相应的网站,从而抓取这个网站中的页面。

对网站来说,如果想要被搜索引擎收录,首先要加入搜索引擎的域名列表。

1、利用搜索引擎提供的网站登录入口,向搜索引擎提交网站的域名。

2、通过外部网站建立链接关系,是搜索引擎可以通过外部网站发现我们的网站,从而实现对网站的收录。只要我们拥有足够多的高质量的链接,这样主动权掌握在我们自己的手里,而且收录速度也比搜索引擎主动提交要快得多。

二、页面抓取

如果把网站页面组成的集合看作是一个有向图,从指定的页面出发,沿着页面中的链接,按照某种特定的策略对网站中的页面进行遍历。不停地从URL列表中移出访问过的URL,并存储原始页面,同时提取原始页面中的URL信息;再将URL分为域名及内部URL两大类,同时判断URL是否访问过,将未被访问过的URL加人URI列表中。递归地扫描URL列表,直至耗尽所有URL资源为止。经过这些工作,搜索引就可以建立庞大的域名列表、页面URL列表及存储足够多的原始页面。

页面抓取的方式有一下6种方式

- 广度优先

- 深度优先

- 大站优先

- 高权重优先

- 暗1网抓取

- 用户提交

三、避免重复性抓取

网站中的重复信息包括转载内容和镜像内容两大类。搜索引擎在对页面进行分析的时候,必须具备识别重复信息的能力。大量的重复信息不但占用巨大的服务器硬盘空间,而且还会增加用户寻找信息的时间,降低用户体验。但这并不意味着所有重复信息都没有价值,搜索引擎认为转载内容不如原创内容重要,赋予原创内容页面更高的权重,而镜像网站几乎忽略。

四、更新策略

由于搜索引擎不可能一次性抓取到网站中所有的页面,而且网站中页面的数量也会不断的变化,内容也在不断的更新,因此,搜索引擎还需要对已经抓取的页面进行维护、更新,以便能及时获取页面最新消息,抓取更多的新页面。

常见页面维护方式包括:定期抓取、增量抓取、分类定位抓取、历史更新策略及用户体验策略。

定期抓取

定期抓取也称为周期性抓取,即搜索引擎周期性的对网站中已经抓取的页面进行全面更新。更新的时候,把抓取到的新页面替换原有的旧页面,删除不存在的页面,并存储新发现的页面。周期性更新针对的是全部已经抓取的页面,因此更新周期会比较长。这适用于维护页面较少、内容更新缓慢的网站,列入普通的企业网站。但是,由于更新周期十分漫长,不能及时向用户反映更新期间页面变化情况。

增量抓取

增量抓取是通过对已抓取的页而进行定时监控,实现对页面的更新及维护。但是,对网站中的每个页面都进行定时监控是不现实的。基于重要页面携带重要内容的思想以及80/20法则”,搜索引擎只需对网站中部分重要页面进行定时的监控,即可获取网站中相对重要的信息。

因此增量抓取只针对网站中某些重要的页面,而非所有已经抓取的页面,这也是为什么搜索引擎对重要页面的更新周期会更短的原因。例如,内容经常更新的页面,搜索引繁也会经常对其进行更新,从而可以及时发现新内容、新链接,并删除不存在的信息。

由于增量抓取是在原有页面的基础上进行的,因此会大大缩减搜索引擎的抓取时间,还可以及时向用户展示页面中最新的内容。

分类定位抓取

与增量抓取由页面重要性决定不同,分类定位抓取是指根据页面的类别或性质而制定相应更新周期的页面监控方式。例如新闻资讯类页面的更新周期可以精确到每分钟,而下载类页面的更新周期就可以定为一天或更长。

分类定位抓取对不同类别的页面进行分开处理,这样就可以节省大量的抓取时间,并大大提高页面内容的实时性,增强页面抓取的灵活性。但是,按照类别制定页面更新周期的方式比较笼统,很难跟踪页面的更新情况。因为即使是相同类别的页面,在不同的网站上内容的更新周期也会存在很大的差别。例如新闻类页面,在大型门户网站中内容的更新速度就会比其它小型网站快得多。所以,还需要结合其它的方式(例如增量抓取等)对页面进行监控和更新。

实际上,搜索引擎对网站中页面的维护也是结合多种方式进行的,相当于间接为每一个页面选择最合适的维护方式。这样,既可以减少搜索引擎的负担,又可以为用户提供及时的信息。

例如,一个网站中会存在多种不同性质的页面,常见的包括:首页、论坛页面、内容页面等。对于更新比较频繁的页面(例如首页),可以使用增量抓取方式对其进行监控,这样就可以对网站中相对重要的页面进行及时更新;而对于实时性非常高的论坛页面,则可以采用分类定位的抓取方式;为了防止遗漏网站中的某些页面,还需要采用定期抓取的方式。

历史更新频率策略

历史更新频率策略基于这样一种思想:某个网页在过去某段时间内频繁更新,那么在将来的某个时间里也可能会频繁更新。例如,对于某网站的首页,通过对它进行的监控可以分析出它的内容更新规律,搜索引擎就可以据此调整对它的抓取频率及时间点,从而及时获得最新内容。

用户体验策略

所谓的用户体验策略是指为了提高投索引|擎用户体验而制定的针对性的网页更新策略。衡量搜索引擎用户体验有众多指标,而网页更新的及时性是其中一项重要因素。对于搜索引擎中的关键字搜索结果,用户通常只会点击排名前30的页面。因此,只要及时更新排名前30的页面,既可以介绍搜索引擎的资源,提高重要页面的更新频率,也可以满足绝大部分用户获取信息的需求。

页面存储

搜索引擎在抓取页面时,除了存储原始页面外,还会附加系列的信息,例如:文件类型、文件大小、最后修改时间、URL、IP地址、抓取时间等。在把这些信息作为开展某项工作的依据。例如,如果某个文件过大,就可能会被搜索引擎放弃索引;二最后修改时间则按暗示页面更新的日期等。